In manchen Foren wird gerätselt wie man die Autorisierung des Sony PRS-T1 Ebook-Readers aufheben kann.

Die Adobe-Digital-Editions (Ver. 1.7.2) können nicht benutzt werden. Diese zeigen den PRS-T1 gar nicht an wie z.B. einen OYO.

Man muss die entsprechende Sony-Reader Software Reader for PC installieren um die Autorisierung durchzuführen. Die Installationssoftware befindet sich ja auf dem Reader.

Die Autorisierung habe ich über den Menüpunkt Bearbeiten -> Einstellungen bewerkstelligt.

In der Onlinehilfe von Reader for PC steht nun folgendes für das Aufheben der Autorisierung:

- Schalten Sie das Reader-Gerät ein und schließen Sie es dann mit dem mitgelieferten USB-Kabel an Ihren Computer an.

Reader für PC wird startet, und das Reader-Symbol wird in der Quellenleiste angezeigt.

Wenn „Automatischer Start“ deaktiviert ist, starten Sie Reader für PC manuell.- Drücken Sie Umschalttaste+Strg auf der Tastatur.

- Klicken Sie links auf „Autorisierung aufheben“.

- Klicken Sie auf neben „Autorisierung des angeschlossenen Geräts aufheben“.

Alle von Ihnen erworbenen Inhalte werden vom Gerät gelöscht

Das ist aber falsch. Man kann in der Reader for PC Software sooft Umschaltaste+Strg drücken wie man will. Es erscheint gar nichts.

Es fehlt ein kleiner Satz, dass man dies über den Menüpunkt Bearbeiten -> Einstellungen machen muss.

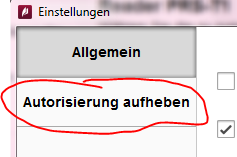

Hier also der Weg zur Deautorisierung:

- Software Reader for PC starten

- Sony PRS-T1 Reader anschließen

- Umschalttaste+Strg drücken und gleichzeitig das Menü Bearbeiten -> Einstellungen öffnen

- Es erscheint ein Dialog in dem die Autorisierung aufgehoben werden kann:

Ich hoffe damit kommt man klar 😉

Nachtrag (01.01.2010): Die Autorisierung eines PCs lässt sich mit der Hilfe der Adobe Digital Editions aufheben. Man startet dazu die Software und drückt die Tastenkombination Strg+Umschalt+D. Damit wird die Autorisierung für diesen PC aufgehoben. Verschlüsselte eBooks lassen sich dann nicht mehr lesen.